Vida Sana

Cuando en febrero un empleado de finanzas de Hong Kong fue convocado a una videoconferencia en directo por el director financiero de su empresa multinacional, todo parecía normal. El director financiero y otros ejecutivos actuaron y sonaron como siempre, aunque el motivo de la reunión era extraño: recibió instrucciones de transferir $25.6 millones a varias cuentas bancarias. Él, por supuesto, hizo lo que su jefe le pidió.

Sorprendentemente, la imagen y la voz del “director financiero” fueron generadas por una computadora, al igual que las de los demás ejecutivos que aparecieron en la llamada. Y las cuentas pertenecían a estafadores. El trabajador fue víctima de una estafa de inteligencia artificial asombrosamente compleja, según informan los medios de comunicación locales. El dinero sigue perdido.

¡ÚLTIMA OPORTUNIDAD! - Únete a AARP a precios del 2024; las tarifas aumentan en el 2025.

Obtén acceso inmediato a productos exclusivos para socios y cientos de descuentos, una segunda membresía gratis y una suscripción a AARP The Magazine.

Únete a AARP

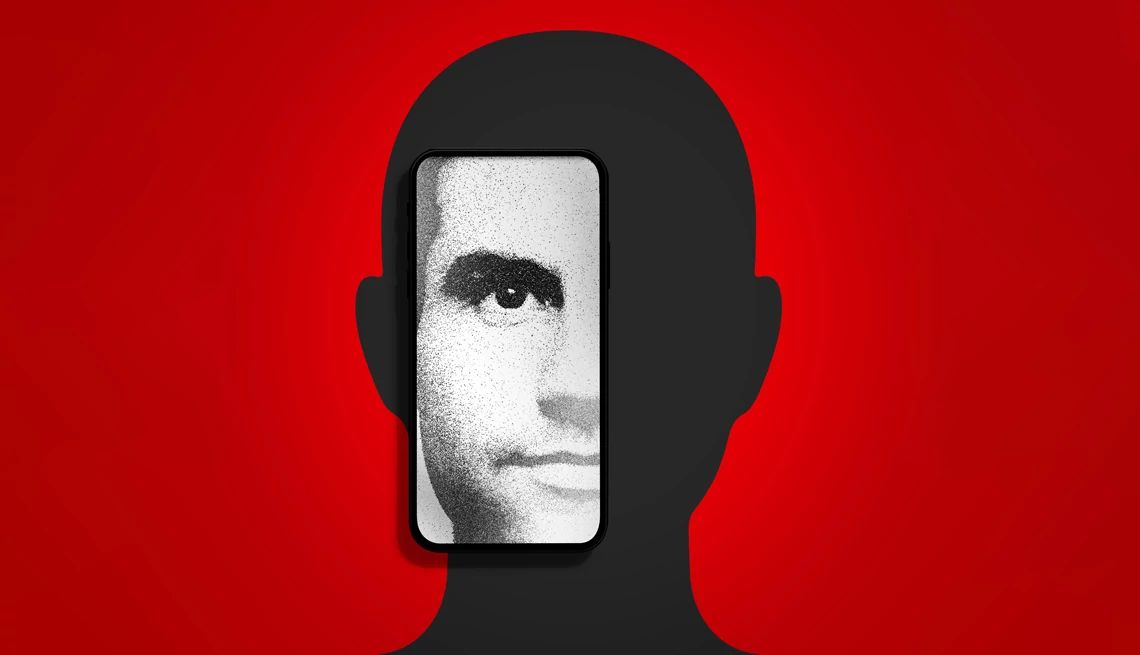

Bienvenido al lado oscuro de la tecnología de IA, en el que las voces y los rostros de personas que conoces pueden falsificarse impecablemente como parte de un esfuerzo por robar tu dinero o tu identidad.

Los científicos llevan décadas programando computadoras para que piensen y hagan predicciones, pero solo en los últimos años la tecnología ha llegado al nivel en el que una computadora puede imitar con eficacia las voces, los movimientos y el estilo de escritura de los humanos y, lo más difícil, predecir lo que una persona podría decir o hacer a continuación. El lanzamiento público en los dos últimos años de herramientas como ChatGPT y DALL-E de OpenAI, Gemini de Google (antes Bard), Copilot de Microsoft y otros programas de IA generativa de fácil acceso han puesto algunas de estas capacidades al alcance de las masas.

Las herramientas de IA pueden ser legítimamente útiles por muchas razones, pero también pueden ser fácilmente utilizadas por los delincuentes para crear voces, sitios web, vídeos y otros contenidos realistas pero falsos para cometer fraudes. Muchos temen que lo peor esté aún por llegar.

Estamos entrando en una “revolución industrial para los delincuentes del fraude”, afirma Kathy Stokes, directora de Programas de Prevención del Fraude de AARP. La IA “abre infinitas posibilidades y, por desgracia, infinitas víctimas y pérdidas”.

Los delincuentes ya están aprovechando algunas de esas “infinitas posibilidades”.

Estafas de famosos. Circuló un vídeo “deepfake” (es decir, una versión falsa de una persona generada por computadora) en el que aparecía el chef Gordon Ramsay avalando los utensilios de cocina HexClad. Era falso. Más tarde, un video similar mostraba a Taylor Swift promocionando Le Creuset. Oprah Winfrey, Kelly Clarkson y otras celebridades han sido imitadas por la IA para vender suplementos para adelgazar.

Estafas de romance. Un hombre de Chicago perdió casi $60,000 dólares en una inversión de criptomonedas que le propuso un estafador de romance que se comunicaba a través de lo que las autoridades creen que era un vídeo falso.

Estafas por extorsión sexual (“sextorsión”). El FBI advierte de que los delincuentes toman fotos y vídeos de las redes sociales de niños y adultos y crean videos falsos explícitos con sus imágenes para extorsionar dinero o favores sexuales.

Eyal Benishti, director ejecutivo y fundador de la empresa de ciberseguridad Ironscales, afirma que la IA puede acortar el proceso de ejecución de prácticamente cualquier estafa. “El superpoder de la IA generativa es que puedes darle un objetivo; por ejemplo, dile: ‘Ve a buscarme 10 ideas diferentes de correos electrónicos de suplantación de identidad sobre cómo puedo atraer a X persona’“.

Cualquiera puede utilizar esta tecnología: “Es como descargar cualquier otra aplicación”, afirma Alex Hamerstone, analista de TrustedSec, una empresa consultora de seguridad informática. “Si estuvieras grabando esta conversación, podrías introducirla en el software y teclear lo que quisieras que dijera, y reproduciría mi voz diciéndolo”.

También te puede interesar

Orden ejecutiva de IA brinda protección contra estafas

La Casa Blanca anuncia esfuerzos para proteger a las personas de los riesgos de la inteligencia artificial.

La FCC prohíbe llamadas automáticas realizadas con IA

La agencia dice que AI realiza llamadas fraudulentas desenfrenadas que podrían engañar a los votantes.

Usan la inteligencia artificial en estafas

Advierten que las nuevas tecnologías ofrecen a los estafadores herramientas para el fraude.